L’IA comme pont entre métiers et IT : quand les réseaux hybrides d’agents réinventent l’analyse de données

Comment l’intelligence artificielle permet enfin aux équipes métiers et IT de parler le même langage — sans compromis sur la rapidité ni la sécurité ?

Le constat : deux mondes qui peinent à se comprendre

D’un côté, les utilisateurs métiers font face à une pression croissante. Les cycles de décision s’accélèrent, les demandes d’analyse se multiplient, et la capacité à répondre vite à une question opérationnelle est devenue un avantage concurrentiel. Mais pour obtenir une réponse, il faut souvent formuler un besoin technique, attendre qu’un développeur ou un analyste BI le traduise en requête, puis valider le résultat. Un processus qui peut prendre des jours, voire des semaines.

De l’autre côté, les équipes IT portent une responsabilité tout aussi critique : garantir la sécurité des données, la fiabilité des modèles, le respect des politiques d’accès et la cohérence sémantique des indicateurs. Chaque outil non maîtrisé déployé par un utilisateur métier — le fameux shadow IT — représente un risque : données non fiables, failles de sécurité, perte de traçabilité.

Ce que l’IA change concrètement

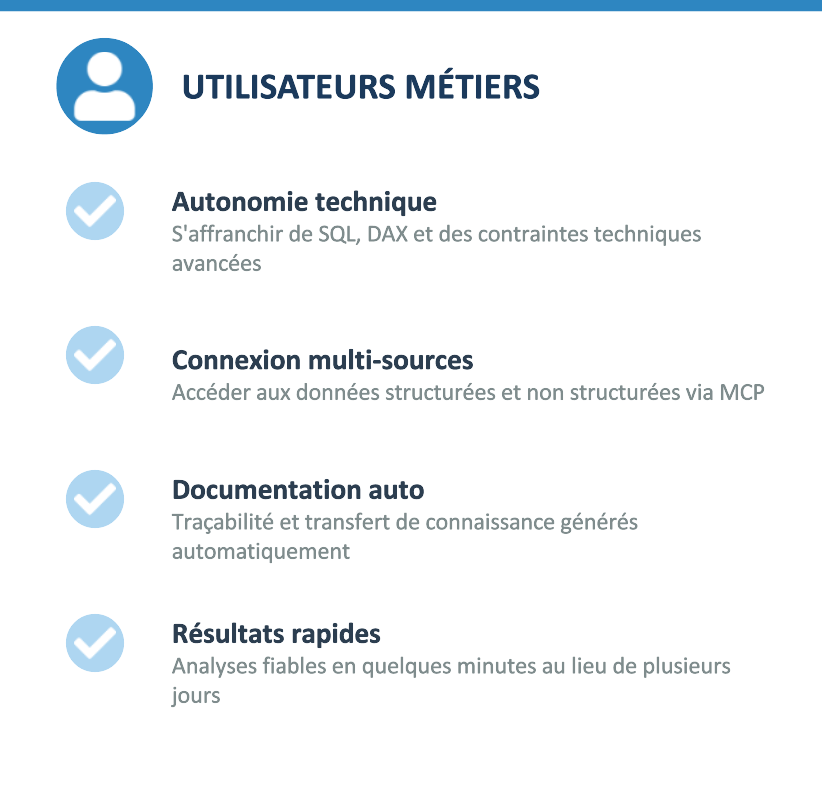

Pour les utilisateurs métiers

S’affranchir des contraintes techniques sans sacrifier la fiabilité. L’utilisateur métier n’a plus besoin de maîtriser SQL, DAX ou les subtilités d’un modèle de données pour obtenir une analyse pertinente. Il exprime son besoin en langage naturel, et l’IA traduit cette demande en actions techniques — requêtes, transformations, visualisations — en s’appuyant sur les définitions métier validées par l’organisation.

Se connecter à des sources multiples de manière transparente. Grâce aux protocoles MCP (Model Context Protocol) et aux API, l’IA peut interroger simultanément des bases de données structurées, des fichiers semi-structurés (Excel, CSV) et des sources non structurées (emails, documents), le tout dans un cadre sécurisé. L’utilisateur n’a pas à se soucier de la plomberie technique.

Générer automatiquement de la documentation. Chaque analyse produite par l’IA peut être accompagnée d’une documentation claire : quelles données ont été utilisées, quelles transformations ont été appliquées, quelles hypothèses sous-tendent les résultats. Cela assure le transfert de connaissance et la traçabilité.

Pour les équipes IT

Prévenir les dérives du shadow IT. Quand les utilisateurs métiers ont un canal rapide et fiable pour obtenir leurs analyses, la tentation de créer des fichiers Excel parallèles ou d’utiliser des outils non référencés diminue considérablement. L’IA canalise les usages au sein d’un écosystème maîtrisé.

Récupérer des modèles de données conformes. L’IA s’appuie sur la couche sémantique définie par l’IT. Les indicateurs, les dimensions, les règles de calcul respectent les définitions officielles. Pas de KPI « maison » dont personne ne connaît la formule.

Garantir l’application des politiques de sécurité. Les accès aux données transitent par les rôles et autorisations en place. L’IA n’ouvre pas de porte dérobée — elle opère dans le cadre des permissions existantes.

Recevoir des besoins clairement formulés et documentés.Lorsqu’un utilisateur métier interagit avec l’IA pour construire une analyse, le processus produit naturellement une trace structurée du besoin. L’IT dispose ainsi d’une spécification implicite, exploitable pour industrialiser ou faire évoluer la solution.

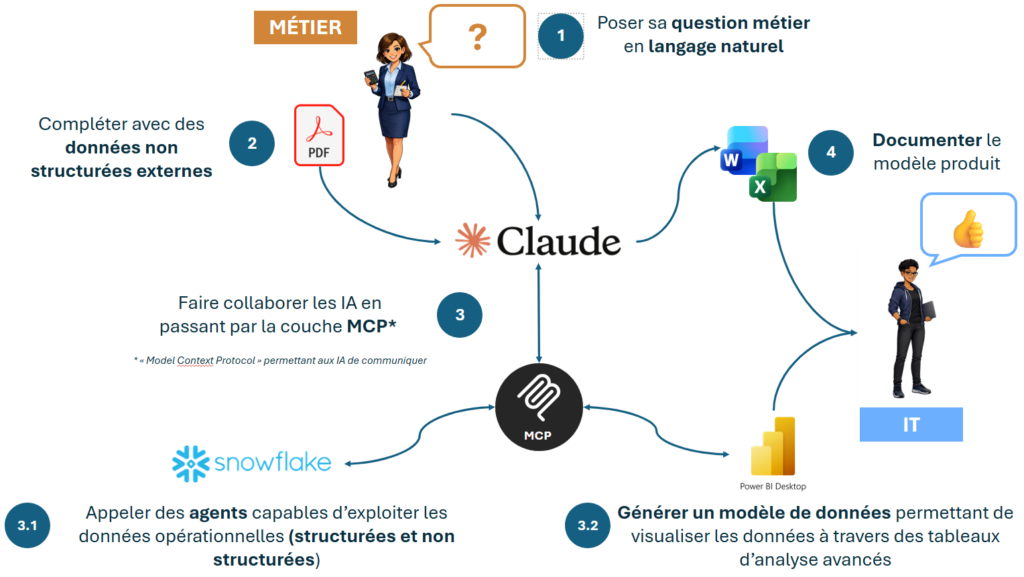

Schéma d’ensemble

Illustration concrète : l’analyse de comparabilité d’un parc de magasins

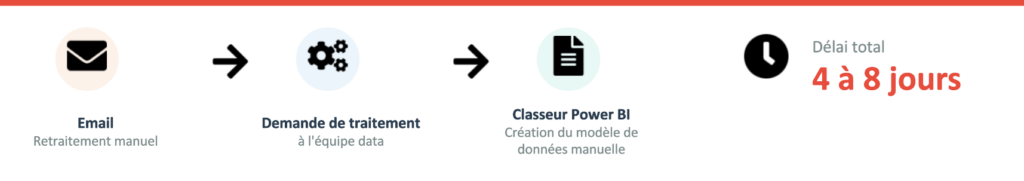

Avant, des étapes manuelles qui passent par plusieurs équipes

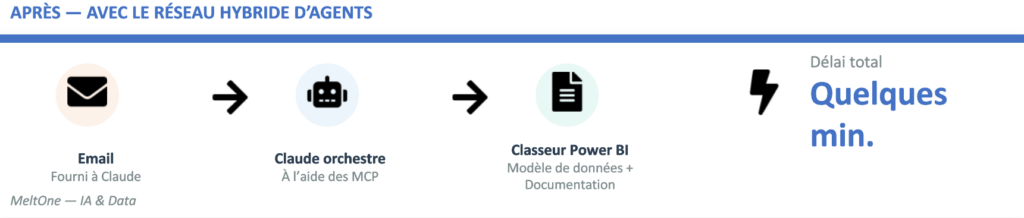

Après, avec un réseau hybride d’agents : le même workflow en quelques minutes et en autonomie

Étape 1 — Compréhension du besoin et récupération des données email. L’utilisatrice fournit à Claude le fichier reçu par email contenant la liste des magasins en travaux. Claude lit et interprète le contenu, identifie les magasins concernés, les dates de travaux et les informations associées.

Étape 2 — Connexion à Snowflake via MCP. Claude interroge les agents Cortex de Snowflake pour récupérer les données de ventes des magasins identifiés. Il s’appuie sur la couche sémantique pour utiliser les bons indicateurs (CA net, CA comparable, nombre de transactions…) avec leurs définitions officielles. Les rôles et autorisations Snowflake s’appliquent normalement.

Étape 3 — Croisement et analyse. Claude croise les données de travaux avec les données de ventes, identifie les périodes de comparabilité, et construit l’analyse demandée : comparaison avant/pendant/après travaux, par zone géographique, par type de magasin.

Étape 4 — Génération du classeur Power BI. Claude génère le modèle de données et les mesures DAX nécessaires, puis crée le classeur Power BI directement sur le poste de l’utilisatrice. Les visualisations sont prêtes à l’emploi.

Étape 5 — Documentation automatique. L’ensemble du processus est documenté : sources de données utilisées, transformations appliquées, hypothèses de comparabilité retenues. Cette documentation est exploitable à la fois par l’utilisatrice et par l’équipe IT.

Les outils de la démonstration

| Outil | Rôle | Contribution |

| Snowflake | Source de données et intelligence métier | Héberge les données de ventes, expose la couche sémantique et met à disposition des agents Cortex respectant les définitions métier |

| Power BI | Modélisation et visualisation | Structure le modèle de données, crée les mesures DAX et produit les visualisations dans un classeur exploitable |

| Claude | Orchestrateur IA | Connecte les outils via MCP, comprend le besoin métier, coordonne les agentsSnowflake, génère le livrable Power BI et la documentation |

Le protocole MCP (Model Context Protocol) est la clé de voûte technique de cette architecture. Il permet à Claude de se connecter de manière standardisée et sécurisée à différents outils — ici Snowflake et Power BI — sans développement d’intégration spécifique. C’est ce qui rend le workflow fluide et reproductible.

Et ensuite ?

Nous commençons avec ce type de cas d’usage à toucher du doigt la transformation profonde que le monde de la data et de l’analyse de données est en train de connaître.

En effet, le rapport entre expertise technique et fonctionnelle est en train de s’inverser. Nous sommes convaincus chez MeltOne que la data sera de moins en moins un sujet d’expertise technique et de plus en plus un sujet d’expertise fonctionnelle. Il s’agira d’être capable de comprendre pleinement les besoins métier et de savoir les définir correctement dans les outils à travers les différentes couches sémantiques.

Ce cas d’usage illustre une application concrète dans le domaine du Retail, mais le potentiel est bien plus large. Dans les prochains articles, nous explorerons des cas d’usage dans d’autres fonctions — Supply Chain, Finance, RH, … — et nous approfondirons un sujet crucial : les moyens de contrôler et d’améliorer la qualité des résultats produits par l’IA.